NVIDIA và Google Cloud vừa tuyên bố hợp tác với nhau, cùng nhau giúp các startup trên toàn thế giới đẩy nhanh việc tạo ra các ứng dụng và dịch vụ AI thế hệ mới.

Thông báo hợp tác lần này của NVIDIA và Google Cloud được đưa ra tại sự kiện Google Cloud Next 2024, kết hợp chương trình NVIDIA Inception dành cho startup với chương trình Google For Startups Cloud. Điều này giúp mở rộng quyền truy cập vào các tín dụng đám mây, hỗ trợ ra mắt thị trường và hỗ trợ các chuyên môn kỹ thuật để giúp startup mang lại giá trị cho khách hàng nhanh hơn.

Các thành viên đủ điều kiện của NVIDIA Inception (một chương trình toàn cầu hỗ trợ hơn 18,000 startup) sẽ có con đường nhanh chóng để sử dụng cơ sở hạ tầng Google Cloud với quyền truy cập vào tín dụng Google Cloud lên đến 350,000 USD cho những startup tập trung vào AI.

Các thành viên của chương trình Google For Startups Cloud có thể tham gia NVIDIA Inception và có quyền truy cập vào các khoá học chuyên sâu của NVIDIA Deep Learning Institute, cùng với phần cứng và phần mềm của NVIDIA,… Các thành viên đủ điều kiện của chương trình Google For Startups Cloud cũng có thể tham gia ngược lại với NVIDIA Inception Capital Connect, một nền tảng giúp startup tiếp cận với các công ty đầu tư mạo hiểm quan tâm đến lĩnh vực này.

Sự hợp tác này là mới nhất trong một loạt các thông báo mà hai công ty đã đưa ra để giúp giảm chi phí và rào cản liên quan đến việc phát triển các ứng dụng AI thế hệ mới cho các doanh nghiệp ở mọi quy mô. Vấn đề chi phí luôn là những hạn chế cho các startup liên quan đến AI.

Nền tảng AI toàn diện

Tháng 2, Google DeepMind đã hé lộ về Gemma, một nhóm các mô hình mở hàng đầu hiện nay. NVIDIA, hợp tác với Google và gần đây đã ra mắt các tối ưu hóa trên tất cả các nền tảng AI của NVIDIA cho Gemma, giúp giảm chi phí cho khách hàng và đẩy nhanh công việc sáng tạo cho nhiều trường hợp sử dụng chúng theo lĩnh vực cụ thể.

Các nhóm từ hai công ty đã hợp tác với nhau để tăng tốc hiệu suất của Gemma, đây vốn là nhóm mô hình mở được xây dựng từ cùng nghiên cứu và công nghệ được sử dụng để tạo ra mô hình có khả năng nhất của nhóm Google DeepMind cho đến nay, chính là Gemini với NVIDIA TensorRT-LLM.

Các dịch vụ vi mô NVIDIA NIM vốn là một phần của nền tảng phần mềm NVIDIA AI Enterprise, cùng với Google Kubernetes Engine (GKE) sẽ cung cấp một con đường đơn giản để phát triển các ứng dụng chạy bằng AI và triển khai các mô hình AI được tối ưu hóa vào sản xuất. NVIDIA NIM được xây dựng trên các engine suy luận bao gồm NVIDIA Triton Inference Server và TensorRT-LLM, sẽ hỗ trợ nhiều mô hình AI hàng đầu khác và cung cấp các suy luận AI liền mạch, có thể mở rộng để đẩy nhanh việc triển khai AI thế hệ mới trong các doanh nghiệp.

Nhóm mô hình Gemma, bao gồm Gemma 7B, RecurrentGemma và CodeGemma sẽ có sẵn từ danh mục API của NVIDIA để người dùng thử từ trình duyệt, tạo các nguyên mẫu với các điểm cuối API và tự lưu trữ với NIM.

Google Cloud đã giúp việc triển khai khung NVIDIA NeMo trên toàn bộ nền tảng của mình dễ dàng hơn thông qua GKE và Google Cloud HPC Toolkit. Điều này cho phép các nhà phát triển tự động hóa và mở rộng quy mô đào tạo cho các mô hình AI thế hệ mới, cho phép họ triển khai nhanh chóng các môi trường hoàn chỉnh thông qua các bản thiết kế có thể tùy chỉnh giúp khởi động quá trình phát triển nhanh hơn.

NVIDIA NeMo, một phần của NVIDIA AI Enterprise cũng sẽ có trên Google Cloud Marketplace, cung cấp cho khách hàng một cách khác để dễ dàng truy cập NeMo và các framework khác để đẩy nhanh phát triển AI.

Để mở rộng hơn nữa tính khả dụng của AI tạo sinh thế hệ mới được tăng tốc với NVIDIA, Google Cloud cũng thông báo rằng A3 Mega sẽ sẵn sàng để sử dụng rộng rãi vào tháng tới. Các phiên bản này là sự mở rộng cho nhóm máy ảo A3 hiện có, được hỗ trợ bởi GPU NVIDIA H100 Tensor Core. Điểm cải tiến đáng chú ý là băng thông mạng giữa các GPU sẽ được tăng gấp đôi so với VM A3.

Ngoài ra, Google Cloud cũng giới thiệu máy ảo bảo mật mới trên A3 với khả năng hỗ trợ điện toán bảo mật. Tính năng này giúp khách hàng bảo vệ tính bảo mật và toàn vẹn của dữ liệu nhạy cảm, đồng thời đảm bảo an toàn cho các ứng dụng và khối lượng công việc AI trong quá trình đào tạo và suy luận.

GPU dựa trên nền tảng NVIDIA Blackwell

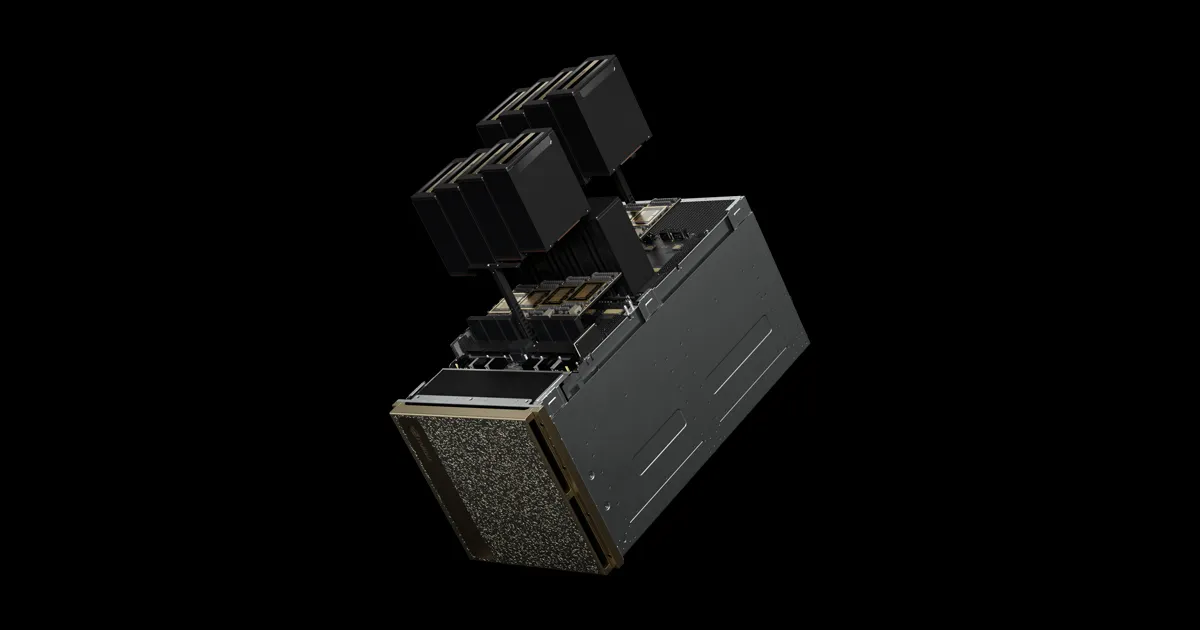

Các GPU mới nhất của NVIDIA dựa trên nền tảng NVIDIA Blackwell sẽ có mặt trên Google Cloud vào đầu năm sau với hai biến thể: NVIDIA HGX B200 và NVIDIA GB200 NVL72.

HGX B200 được thiết kế cho các khối lượng công việc AI, phân tích dữ liệu và điện toán hiệu năng cao đòi hỏi khắt khe nhất, trong khi GB200 NVL72 được thiết kế để đào tạo các mô hình quy mô lớn, với hàng nghìn tỷ tham số và suy luận theo thời gian thực.

NVIDIA GB200 NVL72 kết nối 36 Grace Blackwell Superchip, mỗi chip kết hợp hai GPU NVIDIA Blackwell với một CPU NVIDIA Grace thông qua kết nối chip-to-chip tốc độ 900GB/s, hỗ trợ tối đa 72 GPU Blackwell trong một NVIDIA NVLink và băng thông 130TB/s. Đây là hệ thống rack-scale đa nút, sẽ được kết hợp với hệ thống làm mát bằng chất lỏng tiên tiến thế hệ thứ tư của Google Cloud.

Hồi tháng trước NVIDIA đã thông báo rằng NVIDIA DGX Cloud, một nền tảng AI dành cho các nhà phát triển doanh nghiệp được tối ưu hóa cho nhu cầu của AI tổng hợp, đã có trên VM A3 được hỗ trợ bởi GPU H100. DGX Cloud với GB200 NVL72 cũng sẽ có trên Google Cloud vào năm 2025.

Theo Công nghệ Việt

Thông báo hợp tác lần này của NVIDIA và Google Cloud được đưa ra tại sự kiện Google Cloud Next 2024, kết hợp chương trình NVIDIA Inception dành cho startup với chương trình Google For Startups Cloud. Điều này giúp mở rộng quyền truy cập vào các tín dụng đám mây, hỗ trợ ra mắt thị trường và hỗ trợ các chuyên môn kỹ thuật để giúp startup mang lại giá trị cho khách hàng nhanh hơn.

Các thành viên đủ điều kiện của NVIDIA Inception (một chương trình toàn cầu hỗ trợ hơn 18,000 startup) sẽ có con đường nhanh chóng để sử dụng cơ sở hạ tầng Google Cloud với quyền truy cập vào tín dụng Google Cloud lên đến 350,000 USD cho những startup tập trung vào AI.

Các thành viên của chương trình Google For Startups Cloud có thể tham gia NVIDIA Inception và có quyền truy cập vào các khoá học chuyên sâu của NVIDIA Deep Learning Institute, cùng với phần cứng và phần mềm của NVIDIA,… Các thành viên đủ điều kiện của chương trình Google For Startups Cloud cũng có thể tham gia ngược lại với NVIDIA Inception Capital Connect, một nền tảng giúp startup tiếp cận với các công ty đầu tư mạo hiểm quan tâm đến lĩnh vực này.

Sự hợp tác này là mới nhất trong một loạt các thông báo mà hai công ty đã đưa ra để giúp giảm chi phí và rào cản liên quan đến việc phát triển các ứng dụng AI thế hệ mới cho các doanh nghiệp ở mọi quy mô. Vấn đề chi phí luôn là những hạn chế cho các startup liên quan đến AI.

Nền tảng AI toàn diện

Tháng 2, Google DeepMind đã hé lộ về Gemma, một nhóm các mô hình mở hàng đầu hiện nay. NVIDIA, hợp tác với Google và gần đây đã ra mắt các tối ưu hóa trên tất cả các nền tảng AI của NVIDIA cho Gemma, giúp giảm chi phí cho khách hàng và đẩy nhanh công việc sáng tạo cho nhiều trường hợp sử dụng chúng theo lĩnh vực cụ thể.

Các nhóm từ hai công ty đã hợp tác với nhau để tăng tốc hiệu suất của Gemma, đây vốn là nhóm mô hình mở được xây dựng từ cùng nghiên cứu và công nghệ được sử dụng để tạo ra mô hình có khả năng nhất của nhóm Google DeepMind cho đến nay, chính là Gemini với NVIDIA TensorRT-LLM.

Các dịch vụ vi mô NVIDIA NIM vốn là một phần của nền tảng phần mềm NVIDIA AI Enterprise, cùng với Google Kubernetes Engine (GKE) sẽ cung cấp một con đường đơn giản để phát triển các ứng dụng chạy bằng AI và triển khai các mô hình AI được tối ưu hóa vào sản xuất. NVIDIA NIM được xây dựng trên các engine suy luận bao gồm NVIDIA Triton Inference Server và TensorRT-LLM, sẽ hỗ trợ nhiều mô hình AI hàng đầu khác và cung cấp các suy luận AI liền mạch, có thể mở rộng để đẩy nhanh việc triển khai AI thế hệ mới trong các doanh nghiệp.

Nhóm mô hình Gemma, bao gồm Gemma 7B, RecurrentGemma và CodeGemma sẽ có sẵn từ danh mục API của NVIDIA để người dùng thử từ trình duyệt, tạo các nguyên mẫu với các điểm cuối API và tự lưu trữ với NIM.

Google Cloud đã giúp việc triển khai khung NVIDIA NeMo trên toàn bộ nền tảng của mình dễ dàng hơn thông qua GKE và Google Cloud HPC Toolkit. Điều này cho phép các nhà phát triển tự động hóa và mở rộng quy mô đào tạo cho các mô hình AI thế hệ mới, cho phép họ triển khai nhanh chóng các môi trường hoàn chỉnh thông qua các bản thiết kế có thể tùy chỉnh giúp khởi động quá trình phát triển nhanh hơn.

NVIDIA NeMo, một phần của NVIDIA AI Enterprise cũng sẽ có trên Google Cloud Marketplace, cung cấp cho khách hàng một cách khác để dễ dàng truy cập NeMo và các framework khác để đẩy nhanh phát triển AI.

Để mở rộng hơn nữa tính khả dụng của AI tạo sinh thế hệ mới được tăng tốc với NVIDIA, Google Cloud cũng thông báo rằng A3 Mega sẽ sẵn sàng để sử dụng rộng rãi vào tháng tới. Các phiên bản này là sự mở rộng cho nhóm máy ảo A3 hiện có, được hỗ trợ bởi GPU NVIDIA H100 Tensor Core. Điểm cải tiến đáng chú ý là băng thông mạng giữa các GPU sẽ được tăng gấp đôi so với VM A3.

Ngoài ra, Google Cloud cũng giới thiệu máy ảo bảo mật mới trên A3 với khả năng hỗ trợ điện toán bảo mật. Tính năng này giúp khách hàng bảo vệ tính bảo mật và toàn vẹn của dữ liệu nhạy cảm, đồng thời đảm bảo an toàn cho các ứng dụng và khối lượng công việc AI trong quá trình đào tạo và suy luận.

GPU dựa trên nền tảng NVIDIA Blackwell

Các GPU mới nhất của NVIDIA dựa trên nền tảng NVIDIA Blackwell sẽ có mặt trên Google Cloud vào đầu năm sau với hai biến thể: NVIDIA HGX B200 và NVIDIA GB200 NVL72.

HGX B200 được thiết kế cho các khối lượng công việc AI, phân tích dữ liệu và điện toán hiệu năng cao đòi hỏi khắt khe nhất, trong khi GB200 NVL72 được thiết kế để đào tạo các mô hình quy mô lớn, với hàng nghìn tỷ tham số và suy luận theo thời gian thực.

NVIDIA GB200 NVL72 kết nối 36 Grace Blackwell Superchip, mỗi chip kết hợp hai GPU NVIDIA Blackwell với một CPU NVIDIA Grace thông qua kết nối chip-to-chip tốc độ 900GB/s, hỗ trợ tối đa 72 GPU Blackwell trong một NVIDIA NVLink và băng thông 130TB/s. Đây là hệ thống rack-scale đa nút, sẽ được kết hợp với hệ thống làm mát bằng chất lỏng tiên tiến thế hệ thứ tư của Google Cloud.

Hồi tháng trước NVIDIA đã thông báo rằng NVIDIA DGX Cloud, một nền tảng AI dành cho các nhà phát triển doanh nghiệp được tối ưu hóa cho nhu cầu của AI tổng hợp, đã có trên VM A3 được hỗ trợ bởi GPU H100. DGX Cloud với GB200 NVL72 cũng sẽ có trên Google Cloud vào năm 2025.

Theo Công nghệ Việt