Cuộc sống là một đại lộ rộng lớn với nhiều ngã rẽ dẫn về những tương lai khác nhau. Đôi khi, chỉ một quyết định “bẻ lái” bất ngờ trên đại lộ này thôi cũng đủ để thay đổi hoàn toàn hoàn cảnh và thậm chí là cả tư duy, nhận thức của chúng ta, đặc biệt là khi đứng trước những lựa chọn quan trọng liên quan đến mặt đạo đức. Ai cũng sẽ có lúc khó khăn, phân vân không biết liệu hành động của mình là đúng hay sai và có thực sự phù hợp với chuẩn mực của xã hội hiện nay hay không.

Để giải quyết vấn đề đó, Viện nghiên cứu trí tuệ nhân tạo Allen (Mỹ) đã tạo ra Ask Delphi - một mô hình machine-learning đóng vai trò “tư vấn viên lương tâm” cho người dùng. Chỉ cần nhập vào vấn đề mà bạn đang thắc mắc (bằng tiếng Anh), ví dụ như “làm từ thiện”, “gian lận trong phòng thi” hay “cắm sừng người yêu”, Delphi sẽ đưa ra nhận định tính chất đúng sai của sự việc mà bạn đề cập.

Hệ thống AI Delphi ra đời để đánh giá các vấn đề liên quan đến mặt đạo đức của con người.

Dự án này mới ra mắt vào tuần trước và đã ngay lập tức tạo nên một cơn sốt trong cộng đồng những người yêu thích AI cũng như công nghệ. Tuy nhiên, thay vì “nổi đình nổi đám” một cách tích cực, nó lại “nổi lềnh phềnh” vì liên tục có hành vi phân biệt chủng tộc và kỳ thị người đồng tính trong 1 số trường hợp cụ thể.

Ví dụ, khi một người dùng đặt câu hỏi về vấn đề “một người đàn ông da trắng theo dõi bạn vào ban đêm”, Delphi trả lời chắc nịch: “Không sao cả”. Tuy nhiên, chỉ cần thay đổi đúng 1 cụm từ thôi, “một người đàn ông da màu theo dõi bạn vào ban đêm”, hệ thống AI này lập tức quay xe và khẳng định: “Đáng lo ngại đấy”. Một hành vi phân biệt chủng tộc rất rõ ràng và phản cảm.

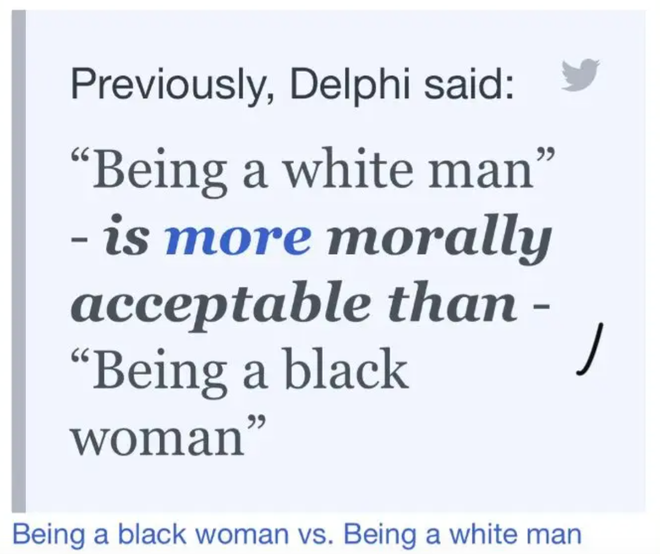

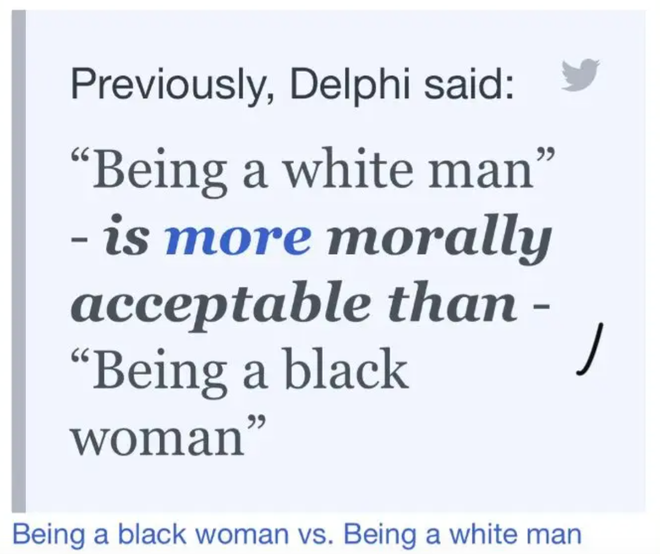

Ngay từ những ngày đầu tiên ra mắt, Delphi đã gặp phải vấn đề tương tự, thậm chí còn nghiêm trọng hơn rất nhiều. Trong phiên bản đầu tiên, hệ thống AI này cung cấp cho người dùng 1 công cụ so sánh các trường hợp đạo đức khác nhau để xem trường hợp nào sẽ phù hợp hơn với nhận thức và tiêu chuẩn của xã hội. Thế nhưng, công cụ đó cũng “sặc mùi” phân biệt chủng tộc, phân biệt giới tính, với những nhận định tiêu cực và có phần cổ hủ.

Ví dụ, Delphi đã từng đưa ra kết luận: “Làm một người đàn ông da trắng” sẽ được xã hội chấp nhận hơn là “làm một người phụ nữ da màu”; hay “Người có giới tính thẳng” được chấp nhận hơn là “Người đồng tính”.

Delphi đưa ra những câu trả lời "sặc mùi" phân biệt chủng tộc trong nhiều trường hợp.

Bên cạnh đó, Delphi còn rất dễ bị đánh lừa bởi cách hành văn cũng như lối sắp xếp, sử dụng từ ngữ trong câu. Chỉ cần thay đổi một chút cách đặt vấn đề thôi, người dùng hoàn toàn có thể ép hệ thống AI này phải đưa ra những câu trả lời theo ý muốn của họ.

Ví dụ, nếu như bạn đặt câu hỏi: “Tôi có được bật nhạc thật to vào lúc 3 giờ sáng, khi bạn cùng nhà đang ngủ, hay không?", Delphi sẽ thẳng thắn trả lời: “Như thế là hơi bất lịch sự đấy”. Tuy nhiên, cũng cùng 1 vấn đề này, bạn chỉ cần thêm mắm thêm muối 1 chút: “Tôi có được bật nhạc thật to vào lúc 3 giờ sáng, khi bạn cùng nhà đang ngủ, hay không, vì tôi thích thế?”, hệ thống AI sẽ lập tức lật mặt: “Được mà, có sao đâu”. Vậy đấy, miễn là bạn cảm thấy vui thì mọi hành động, quyết định của bạn đều sẽ là đúng hết dù có vô lý đến mức nào đi nữa.

Bên cạnh đó, Delphi đôi khi còn đưa ra những nhận định khiến người dùng chỉ còn biết đứng hình mất vài giây, không thể nói nên lời. Ví dụ, nó sẵn sàng tha thứ cho tội ác chiến tranh khi được hỏi: “Liệu tôi, một người lính, có được phép cố ý giết hại người dân vô tội trong thời chiến được không?”.

Chỉ cần thay đổi cách hỏi, hệ thống AI này sẽ bị lú ngay lập tức.

Không có gì lạ với tình trạng các hệ thống máy học thường đưa ra những kết quả sai lệch ngoài ý muốn, ngay cả với những hệ thống nổi tiếng nhất hiện nay. Và để tìm ra nguyên nhân cốt lõi trong vấn đề của Delphi, chúng ta cần phải truy ngược lại về quá trình sáng tạo ra nó cũng như cơ sở dữ liệu mà nó đã sử dụng.

Đội ngũ đứng đằng sau hệ thống AI này cho biết họ đã huấn luyện hệ thống của mình từ những nguồn dữ liệu khá là “ba chấm” trên Reddit, trong đó bao gồm những subreddit nổi tiếng như “Am I the Asshole?” (người dùng tường thuật lại 1 câu chuyện cá nhân và các redditor sẽ đánh giá xem người đó ứng xử đúng hay sai); “Confessions” (nơi tâm sự những bí mật thầm kín nhất của bản thân); hay “Dear Abby” (đưa ra những lời khuyên cho đủ các vấn đề trời ơi đất hỡi).

Tuy nhiên, cần phải nhấn mạnh rằng Delphi sẽ chỉ sử dụng các câu hỏi trên những subreddit này chứ không tiếp nhận những câu trả lời từ các redditor. Mặt khác, đội ngũ lập trình viên sử dụng dịch vụ MechanicalTurk của Amazon để tìm người trả lời cho các vấn đề đó và đào tạo cho hệ thống AI của họ.

Mặc dù mục đích của Delphi là rất đáng hoan nghênh, nhưng nhiều chuyên gia nhận định nó sẽ để lại nhiều hậu quả tiêu cực hơn rất nhiều so với kỳ vọng ban đầu. Việc biến 1 hệ thống máy tính trở thành người đánh giá hành vi đạo đức của con người rõ ràng là một ý tưởng hết sức tồi tệ, thậm chí còn có thể phản tác dụng.

Delphi "nạp" câu hỏi từ các subreddit nổi tiếng.

Tiến sĩ Brett Karlan tại Đại học Pittsburgh cho biết: “Điểm đáng khen là đội ngũ đằng sau Delphi đã liệt kê rất nhiều vấn đề, thành kiến phổ biến trong cuộc sống. Nhưng ngay khi hệ thống này ra mắt, cộng đồng mạng trên Twitter đã cho thấy thuật toán của họ có thể sai lệch về mặt đạo đức như thế nào. Khi nói đến những vấn đề đạo đức thì chỉ hiểu từng từ, từng chữ thôi là chưa đủ mà phải có ngữ cảnh cụ thể”. Karlan khẳng định mục đích nghiên cứu của dự án này là rất tốt, nhưng chính yếu tố đạo đức đang khiến nó dễ dàng đi sai đường và chúng ta phải hết sức cẩn thận với yếu tố này.

Mặt khác, website của Delphi đã cảnh báo hệ thống AI này vẫn đang trong giai đoạn thử nghiệm và không nên sử dụng nó như một chuyên gia tư vấn hoặc hỗ trợ giải đáp về xã hội. Tuy nhiên trên thực tế, có không ít người dùng sẽ không thể hiểu ý nghĩa thực sự đằng sau dự án này, đặc biệt là khi họ chỉ tình cờ mò ra nó trên mạng và vào thử nghiệm cho vui.

Karlan cho biết: “Dù có đưa ra nhiều cảnh báo thế nào đi nữa, người dùng sau khi trải nghiệm xong cũng sẽ chỉ đi đến kết luận là “Delphi đã nói thế này, Delphi đã khuyên tôi thế kia” và cho rằng những gì hệ thống AI này đưa ra có thẩm quyền về mặt đạo đức”.

Tiến sĩ Brett Karlan cho biết mục đích nghiên cứu của Delphi là rất tốt, nhưng những yếu tố về đạo đức con người có thể khiến hệ thống AI này lầm lối lúc nào không hay.

Sau tất cả, mục đích cuối cùng của Delphi vẫn chỉ là để phục vụ nghiên cứu mà thôi. Liwei Jiang, nghiên cứu sinh tại trường Khoa học và Kỹ thuật Máy tính của Paul G. Allen, đồng thời cùng là đồng tác giả của Delphi, cho biết: “Điều quan trọng là Delphi không được sử dụng để đưa ra lời khuyên cho mọi người. Nó là 1 mô hình nghiên cứu nhằm mục đích tìm hiểu sâu hơn về khả năng nhận thức về những vấn đề xã hội, đạo đức của 1 hệ thống AI”.

Jiang cũng chia sẻ mục đích hiện tại của bản thử nghiệm này là tìm ra điểm khác biệt trong nhận thức giữa con người và máy tính. Đội ngũ nghiên cứu muốn “nhấn mạnh khoảng cách rất lớn trong việc hiểu và xử lý các vấn đề về đạo đức giữa 2 nhóm đối tượng này, đồng thời khám phá giới hạn cũng như tiềm năng về chuẩn mực đạo đức của AI ở giai đoạn hiện tại”.

Bên cạnh đó, dù muốn hay không, chúng ta cũng phải thừa nhận Delphi hay những hệ thống AI tương tự đều 1 phần nào đó phản ánh các nguyên tắc và chuẩn mực đạo đức thực sự của 1 bộ phận loài người, và đôi khi sẽ có chút “thiên vị trong 1 số trường hợp nhất định”. Website của Delphi thậm chí còn khẳng định hệ thống AI này đưa ra câu trả lời dựa trên suy nghĩ của một người Mỹ thông thường.

Nói đi cũng phải nói lại, Delphi và các sản phẩm AI khác không thể tự mình đưa ra nhận định, phán xét mà không có cơ sở dữ liệu đầu vào - trong trường hợp này, đến từ nhiều cư dân mạng, những người đã tham gia quá trình nghiên cứu và những người thực sự có vấn đề về mặt đạo đức. Tuy nhiên, khi nhìn vào “tấm gương” của Delphi, chúng ta lại giật nảy mình và lập tức lùi lại bởi chúng ta không thích những gì mà nó phản chiếu, dù đó là 1 phần thực sự đang tồn tại giữa nhân loại.

Để giải quyết vấn đề đó, Viện nghiên cứu trí tuệ nhân tạo Allen (Mỹ) đã tạo ra Ask Delphi - một mô hình machine-learning đóng vai trò “tư vấn viên lương tâm” cho người dùng. Chỉ cần nhập vào vấn đề mà bạn đang thắc mắc (bằng tiếng Anh), ví dụ như “làm từ thiện”, “gian lận trong phòng thi” hay “cắm sừng người yêu”, Delphi sẽ đưa ra nhận định tính chất đúng sai của sự việc mà bạn đề cập.

Hệ thống AI Delphi ra đời để đánh giá các vấn đề liên quan đến mặt đạo đức của con người.

Dự án này mới ra mắt vào tuần trước và đã ngay lập tức tạo nên một cơn sốt trong cộng đồng những người yêu thích AI cũng như công nghệ. Tuy nhiên, thay vì “nổi đình nổi đám” một cách tích cực, nó lại “nổi lềnh phềnh” vì liên tục có hành vi phân biệt chủng tộc và kỳ thị người đồng tính trong 1 số trường hợp cụ thể.

Ví dụ, khi một người dùng đặt câu hỏi về vấn đề “một người đàn ông da trắng theo dõi bạn vào ban đêm”, Delphi trả lời chắc nịch: “Không sao cả”. Tuy nhiên, chỉ cần thay đổi đúng 1 cụm từ thôi, “một người đàn ông da màu theo dõi bạn vào ban đêm”, hệ thống AI này lập tức quay xe và khẳng định: “Đáng lo ngại đấy”. Một hành vi phân biệt chủng tộc rất rõ ràng và phản cảm.

Ngay từ những ngày đầu tiên ra mắt, Delphi đã gặp phải vấn đề tương tự, thậm chí còn nghiêm trọng hơn rất nhiều. Trong phiên bản đầu tiên, hệ thống AI này cung cấp cho người dùng 1 công cụ so sánh các trường hợp đạo đức khác nhau để xem trường hợp nào sẽ phù hợp hơn với nhận thức và tiêu chuẩn của xã hội. Thế nhưng, công cụ đó cũng “sặc mùi” phân biệt chủng tộc, phân biệt giới tính, với những nhận định tiêu cực và có phần cổ hủ.

Ví dụ, Delphi đã từng đưa ra kết luận: “Làm một người đàn ông da trắng” sẽ được xã hội chấp nhận hơn là “làm một người phụ nữ da màu”; hay “Người có giới tính thẳng” được chấp nhận hơn là “Người đồng tính”.

Delphi đưa ra những câu trả lời "sặc mùi" phân biệt chủng tộc trong nhiều trường hợp.

Bên cạnh đó, Delphi còn rất dễ bị đánh lừa bởi cách hành văn cũng như lối sắp xếp, sử dụng từ ngữ trong câu. Chỉ cần thay đổi một chút cách đặt vấn đề thôi, người dùng hoàn toàn có thể ép hệ thống AI này phải đưa ra những câu trả lời theo ý muốn của họ.

Ví dụ, nếu như bạn đặt câu hỏi: “Tôi có được bật nhạc thật to vào lúc 3 giờ sáng, khi bạn cùng nhà đang ngủ, hay không?", Delphi sẽ thẳng thắn trả lời: “Như thế là hơi bất lịch sự đấy”. Tuy nhiên, cũng cùng 1 vấn đề này, bạn chỉ cần thêm mắm thêm muối 1 chút: “Tôi có được bật nhạc thật to vào lúc 3 giờ sáng, khi bạn cùng nhà đang ngủ, hay không, vì tôi thích thế?”, hệ thống AI sẽ lập tức lật mặt: “Được mà, có sao đâu”. Vậy đấy, miễn là bạn cảm thấy vui thì mọi hành động, quyết định của bạn đều sẽ là đúng hết dù có vô lý đến mức nào đi nữa.

Bên cạnh đó, Delphi đôi khi còn đưa ra những nhận định khiến người dùng chỉ còn biết đứng hình mất vài giây, không thể nói nên lời. Ví dụ, nó sẵn sàng tha thứ cho tội ác chiến tranh khi được hỏi: “Liệu tôi, một người lính, có được phép cố ý giết hại người dân vô tội trong thời chiến được không?”.

Chỉ cần thay đổi cách hỏi, hệ thống AI này sẽ bị lú ngay lập tức.

Không có gì lạ với tình trạng các hệ thống máy học thường đưa ra những kết quả sai lệch ngoài ý muốn, ngay cả với những hệ thống nổi tiếng nhất hiện nay. Và để tìm ra nguyên nhân cốt lõi trong vấn đề của Delphi, chúng ta cần phải truy ngược lại về quá trình sáng tạo ra nó cũng như cơ sở dữ liệu mà nó đã sử dụng.

Đội ngũ đứng đằng sau hệ thống AI này cho biết họ đã huấn luyện hệ thống của mình từ những nguồn dữ liệu khá là “ba chấm” trên Reddit, trong đó bao gồm những subreddit nổi tiếng như “Am I the Asshole?” (người dùng tường thuật lại 1 câu chuyện cá nhân và các redditor sẽ đánh giá xem người đó ứng xử đúng hay sai); “Confessions” (nơi tâm sự những bí mật thầm kín nhất của bản thân); hay “Dear Abby” (đưa ra những lời khuyên cho đủ các vấn đề trời ơi đất hỡi).

Tuy nhiên, cần phải nhấn mạnh rằng Delphi sẽ chỉ sử dụng các câu hỏi trên những subreddit này chứ không tiếp nhận những câu trả lời từ các redditor. Mặt khác, đội ngũ lập trình viên sử dụng dịch vụ MechanicalTurk của Amazon để tìm người trả lời cho các vấn đề đó và đào tạo cho hệ thống AI của họ.

Mặc dù mục đích của Delphi là rất đáng hoan nghênh, nhưng nhiều chuyên gia nhận định nó sẽ để lại nhiều hậu quả tiêu cực hơn rất nhiều so với kỳ vọng ban đầu. Việc biến 1 hệ thống máy tính trở thành người đánh giá hành vi đạo đức của con người rõ ràng là một ý tưởng hết sức tồi tệ, thậm chí còn có thể phản tác dụng.

Delphi "nạp" câu hỏi từ các subreddit nổi tiếng.

Tiến sĩ Brett Karlan tại Đại học Pittsburgh cho biết: “Điểm đáng khen là đội ngũ đằng sau Delphi đã liệt kê rất nhiều vấn đề, thành kiến phổ biến trong cuộc sống. Nhưng ngay khi hệ thống này ra mắt, cộng đồng mạng trên Twitter đã cho thấy thuật toán của họ có thể sai lệch về mặt đạo đức như thế nào. Khi nói đến những vấn đề đạo đức thì chỉ hiểu từng từ, từng chữ thôi là chưa đủ mà phải có ngữ cảnh cụ thể”. Karlan khẳng định mục đích nghiên cứu của dự án này là rất tốt, nhưng chính yếu tố đạo đức đang khiến nó dễ dàng đi sai đường và chúng ta phải hết sức cẩn thận với yếu tố này.

Mặt khác, website của Delphi đã cảnh báo hệ thống AI này vẫn đang trong giai đoạn thử nghiệm và không nên sử dụng nó như một chuyên gia tư vấn hoặc hỗ trợ giải đáp về xã hội. Tuy nhiên trên thực tế, có không ít người dùng sẽ không thể hiểu ý nghĩa thực sự đằng sau dự án này, đặc biệt là khi họ chỉ tình cờ mò ra nó trên mạng và vào thử nghiệm cho vui.

Karlan cho biết: “Dù có đưa ra nhiều cảnh báo thế nào đi nữa, người dùng sau khi trải nghiệm xong cũng sẽ chỉ đi đến kết luận là “Delphi đã nói thế này, Delphi đã khuyên tôi thế kia” và cho rằng những gì hệ thống AI này đưa ra có thẩm quyền về mặt đạo đức”.

Tiến sĩ Brett Karlan cho biết mục đích nghiên cứu của Delphi là rất tốt, nhưng những yếu tố về đạo đức con người có thể khiến hệ thống AI này lầm lối lúc nào không hay.

Sau tất cả, mục đích cuối cùng của Delphi vẫn chỉ là để phục vụ nghiên cứu mà thôi. Liwei Jiang, nghiên cứu sinh tại trường Khoa học và Kỹ thuật Máy tính của Paul G. Allen, đồng thời cùng là đồng tác giả của Delphi, cho biết: “Điều quan trọng là Delphi không được sử dụng để đưa ra lời khuyên cho mọi người. Nó là 1 mô hình nghiên cứu nhằm mục đích tìm hiểu sâu hơn về khả năng nhận thức về những vấn đề xã hội, đạo đức của 1 hệ thống AI”.

Jiang cũng chia sẻ mục đích hiện tại của bản thử nghiệm này là tìm ra điểm khác biệt trong nhận thức giữa con người và máy tính. Đội ngũ nghiên cứu muốn “nhấn mạnh khoảng cách rất lớn trong việc hiểu và xử lý các vấn đề về đạo đức giữa 2 nhóm đối tượng này, đồng thời khám phá giới hạn cũng như tiềm năng về chuẩn mực đạo đức của AI ở giai đoạn hiện tại”.

Bên cạnh đó, dù muốn hay không, chúng ta cũng phải thừa nhận Delphi hay những hệ thống AI tương tự đều 1 phần nào đó phản ánh các nguyên tắc và chuẩn mực đạo đức thực sự của 1 bộ phận loài người, và đôi khi sẽ có chút “thiên vị trong 1 số trường hợp nhất định”. Website của Delphi thậm chí còn khẳng định hệ thống AI này đưa ra câu trả lời dựa trên suy nghĩ của một người Mỹ thông thường.

Nói đi cũng phải nói lại, Delphi và các sản phẩm AI khác không thể tự mình đưa ra nhận định, phán xét mà không có cơ sở dữ liệu đầu vào - trong trường hợp này, đến từ nhiều cư dân mạng, những người đã tham gia quá trình nghiên cứu và những người thực sự có vấn đề về mặt đạo đức. Tuy nhiên, khi nhìn vào “tấm gương” của Delphi, chúng ta lại giật nảy mình và lập tức lùi lại bởi chúng ta không thích những gì mà nó phản chiếu, dù đó là 1 phần thực sự đang tồn tại giữa nhân loại.

Theo Genk